[Mostly Weekly #36] AI, DL, ML e altre induzioni

Mostly Weekly #36

La newsletter omonima a margine del canale Telegram

(quella che esce quando è pronta)

A cura di Antonio Dini

Numero 36 ~ 10 novembre 2019

“It is a truism that artificial intelligence research can never become successful, because its successes are not viewed as AI.” – Aaron Hertzman

HEAD

I valori degli altri e quelli delle AI

Una sera, durante una cena di lavoro negli Stati Uniti con alcuni colleghi giornalisti provenienti da tutto il mondo, uscì fuori un termine che non conoscevo: jaywalking. È un reato negli Usa, e riguarda i pedoni che camminano lungo o attraverso le strade riservate al traffico automobilistico. Non solo le autostrada o le strade statali, ci sono dentro anche le semplici strade cittadine. È un esempio di concetto codificato che appartiene a una determinata cultura (quella americana) e non ad altre, inclusa quella italiana.

Adesso una indagine ha portato alla luce nuovi elementi relativi alla prima morte di cui ci sia documentazione dovuta a un incidente con un veicolo a guida completamente autonoma, avvenuta nel marzo del 2018, quando un Uber in prova ha ucciso un pedone che stava facendo jaywalking. Analizzando i dati è stato scoperto che il sistema non ha riconosciuto la persona come un pericolo perché non stava attraversando sulle strisce o in un'area in cui comunque poteva farlo. L'auto ha in effetti riconosciuto la presenza della persona ma l'ha ignorata, classificandolo come "oggetto non pericoloso". A bordo c'era un "autista non guidante", che aveva il ruolo di controllore e doveva essere pronto a intervenire in casi come: era distratto e non l'ha fatto.

Ci sono ancora delle udienze in corso, ci si chiede se in casi come questi ci sia una responsabilità di chi crea il software, Uber (e altri) intanto vanno avanti con le sperimentazioni e ovviamente adesso tutti hanno preso in considerazione anche il jaywalking come possibile scenario durante la guida autonoma. Tuttavia, il punto secondo me è un altro. Il mancato inserimento di questo tipo di comportamento deriva da un pregiudizio dei programmatori (detto in inglese, il famigerato bias) che a sua volta deriva da un condizionamento sociale di chi ha addestrato la AI per cui ha ignorato completamente il caso del jaywaliking. Non l'ha proprio visto, insomma.

Tuttavia, a ben guardare, questo è un caso in negativo di inserimento di valori umani nelle AI. Perché addestrando delle AI si fanno scelte di valori e scelte etiche, soprattutto quando le attività diventano più complesse ed entrano in relazione con la società e i singoli individui. La domanda di conseguenza diventa per me molto più chiara: chi sceglie i valori e l'etica delle AI? E soprattutto, dato che questo definiscono le diverse culture e quindi si differenziano in moltissimi modi, quali sceglie e per chi?

Provate a immaginare un funzionario di banca che deve autorizzare l'erogazione di un mutuo e utilizza una AI come sistema di supporto per valutare la solvibilità del cliente. Immaginate che la AI processi anche informazioni in parte soft (tipologie di acquisti online e non, presenza/assenza sui social e altre attività analoghe). Adesso, chiedetevi: chi ha addestrato quella AI e in quale Paese? Quali correzioni ha fatto durante l'addestramento? Quali "valori" ha ininettato nella rete neurale? Conservatori o Progressisti? Democratici o Repubblicani? Tradizionalisti o liberal?

Adesso intravedete il problema? Il punto non è più di etica dei massimi sistemi, tipo: se l'auto sbanda e deve scegliere se travolgere un bambino o uccidere gli occupanti andando contro il muro chi decide? No, qui siamo a considerazioni molto più quotidiane sulla forma e sul modo con il quale funzionano le nostre società. Una parola che uso volutamente al plurale perché il tema è questo, mantenere le nostre caratteristiche e non venir assimilati da un insieme di valori predefiniti da altri, per di più altrove, e in pratica senza alcun controllo o momento di delega esplicita e verificabile (e quindi di responsabilità).

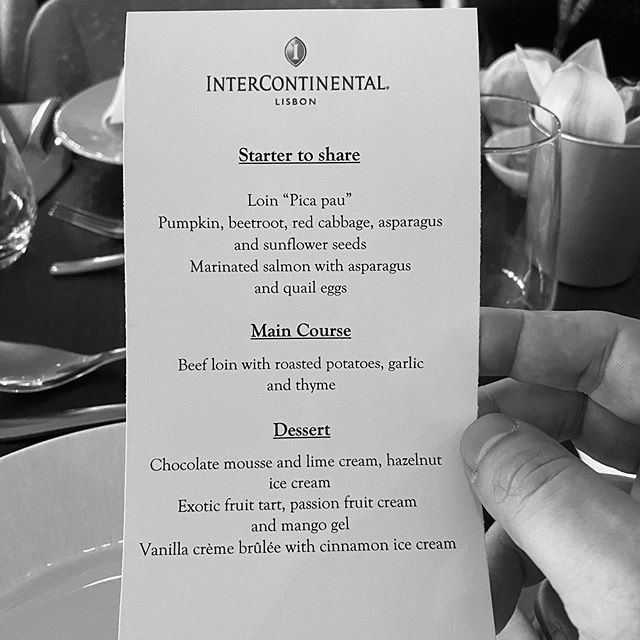

Starter to Share – Foto © Antonio Dini

Starter to Share – Foto © Antonio Dini

Questa settimana è stata piuttosto densa di impegni lavorativi e famigliari. Mostly Weekly è più breve e orientata alle AI.

In questo numero:

- Head

- Body

- Vim Corner

- Tsundoku Regular

- Tsundoku Poetry Room

BODY

Riconoscere le intenzioni

Non c'è bisogno di predire il futuro, basta leggere la mente delle persone per poterne capire le intenzioni. E per riconoscere le intenzioni delle persone senza essere degli scrittori di fantascienza, si comincia riconoscendo le persone e poi le loro emozioni. Le AI cinesi sono già a un buon punto su questo percorso.

Diamo per scontato che entrare nella testa della gente è il sogno di qualsiasi governante, non solo dei despota: qualunque politico occidentale vorrebbe avere uno strumento del genere. In Cina, che non brilla come esempio di democrazia partecipativa (nonostante le premesse del Partito Comunista, voglio dire) i ricercatori sono alacremente al lavoro per realizzare un sistema di "riconoscimento delle emozioni" basato sulla AI. In pratica, l'obiettivo serve a controllare la diversità e l'enormità della popolazione cinese, incluso il milione di musulmani che vivono nello Xinjiang in vari campi di internamento.

Con un sistema di intelligenza artificiale capace di leggere le emozioni delle persone si possono poi capire le loro intenzioni e alla lunga predire i comportamenti, criminogeni e non. Tutte le aziende cinesi che partecipano a questo sforzo sono state bannate dal mercato americano, dove però vengono fatti studi analoghi ma pensati per attività commerciali (per adesso).

Secondo la maggior parte degli esperti un sistema del genere è molto complesso, praticamente non funziona e non c'è garanzia che un giorno riesca. Forse è impossibile. Tutti, da Microsoft a Google passando per Amazon (cioè i tre più interessati assieme a Facebook a realizzare un sistema di questo tipo) ammettono che i loro sistemi di riconoscimento facciale sono rudimentali, ancora molto lontani da capire qualcosa che non sia "sorriso" o "faccia triste".

La Cina ha una strategia di sviluppo di questi sistemi che è complessa e non completamente orwelliana nella sua rappresentazione (cioè, meno distopica di quanto in realtà non sia la differenza rispetto a noialtri in occidente: noi utilizziamo le AI soprattutto per sabotare le elezioni e i candidati avversari con fake news e deep fake) perché mira al controllo del credito degli individui e alla gestione dei crimine in un Paese altrimenti incontrollabile per diversità, tensioni sociali, tentativi di sedizione e via dicendo. Anche la lotta alla diversità religiosa, soprattutto musulmana, è comprensibile e logica, se si capiscono le intenzioni e gli obiettivi di chi governa quella società.

VIM CORNER

Tutorials e guide per AI, DP e ML

È arrivato il momento di lasciare i vostri studi sui big data? La statistica non è più la scienza sexy del futuro? Bisogna riciclarci velocemente in esperti educatori di oggetti software intelligenti, cioè di animaletti digitali? Ecco qua: una prima raccolta di tutorial fatta da Tarry Singh su AI, Deep Learning e Machine Learning, una AI Repository mantenuta da Seonghan Ryu e infine, per chi cerca cose da leggere, c'è Awesome AI creata e gestita da Vidyasagar Machupalli, che è una lista di articoli, libri, corsi, infografiche e molto più sempre su AI, ML e DL. Infine, per chi va di fretta (scherzo!), Stefan Kojouharov ha messo insieme questo cheat sheet che non è affatto male.

Through the window – Foto © Antonio Dini

Through the window – Foto © Antonio Dini

TSUNDOKU REGULAR

Perché, quando si comprano libri e non si leggono ma si accumulano e basta, c'è una parola (giapponese) per dirlo

In questi giorni mi sono capitati fra le mani:

- Io Robot di Isaac Asimov, questa è la raccolta dei racconti degli anni Quaranta del "buon dottore" nei quali erano comparse per la prima volta (e lentamente) le tre leggi della robotica. Ne ho varie edizioni ma mi piace soprattutto la versione del primo numero di Urania Collezione.

- Il ciclo di vita degli oggetti software di Ted Chiang (autore che mi piace molto) l'ho già citato, direttamente o indirettamente, su Mostly Weekly. Sappiate che ne vale decisamente la pena.

- Westworld di Michael Crichton, che è un autore che mi piace molto. Nel 1973 ha scritto e diretto un film (da noi tradotto come Il mondo dei robot) con Yul Brynner. È un soggetto originale e non tratto da un libro, e fu un lavoro seminale per molti motivi. Ci fu poi un seguito (Futureworld del 1976) e poi la serie Tv eponima del 2016 (la terza stagione arriva a inizio 2020). Il tema è quello della coscienza artificiale ovviamente. Partite da questi, se volete vedere qualcosa di non banale.

TSUNDOKU POETRY ROOM

In attesa del ritorno del nostro poet-in-residence Roberto R. Corsi (@rrcorsi), questa settimana siamo AI-oriented anche qui

- Acrostico di computer è stata generata automaticamente su AcrosticosOrg che spiega: «Un acrostico è un poema che ha una 'parola nascosta' e per scoprirla devi leggere il testo in modo diverso. Questa pagina è un generatore automatico di poesie che, allo stesso tempo, crea acrostici, quindi se leggi in verticale la prima lettera di ogni linea della poesia, vedrai la parola 'nascosta' che avevi scritto nel modulo».

I link non hanno alcuna affiliazione, puntano solo all'oggetto culturale citato.

::END::

Ti è piaciuta? Inoltrala a chi potrebbe essere interessato.

Se l'hai ricevuta, qui puoi iscriverti

Se vuoi cancellarti (subito, rapidamente e per sempre) il collegamento invece è più sotto.

Qui invece c'è l'archivio dei numeri passati

Buona domenica!